논문명: DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning

저자: DeepSeek-AI

출간지: SCIENCE CHINA Technological Sciences

발간일: 22 Jan 2025

I. Introduction

LLM의 발전을 언급하며, Post-training이 특히 모델의 성능 향상의 큰 기여를 한다고 한다.

한편, OpenAI의 o1 모델 시리즈는 추론 과정(CoT)의 길이를 늘려 추론 성능을 강화하는 기법을 최초로 도입하여 다양한 영역에서 성과를 보였으나, Test-Time Scalinig 문제는 여전히 해결되지 않는 연구 과제임을 이야기 한다.

* Test-Time Scaling : 모델이 훈련 시와는 다른 추론 환경에서 크거나 더 복잡한 입력을 처리할 때 성능이 크게 저하되는 현상

기존 연구에서는 프로세스 기반 보상 모델, 강화 학습, 검색 알고리즘 등을 활용하여 해결하려 했으나, OpenAI o1 모델 수준의 성능을 달성하진 못 했다. 따라서 본 연구에서 순수 강화 학습(RL)만을 사용하여 LLM의 추론 능력을 향상 시키는 접근 방식을 제안하고자 하는 것이다.

II. Model

본 연구의 목적은 대량의 데이터를 사용하는 지도 학습 대신 강화 학습만으로 추론 능력을 크게 향상시킬 수 있음을 입증하는 것이다. 이 때, 소량의 초기 supervised data를 포함한다면 크게 성능을 향상시킬 수 있다.

| DeepSeek-R1-Zero (이전 모델) |

⦁ 순수 RL만을 이용한 모델로, DeepSeek-V3-Base를 기반으로 만들어진 모델 ⦁ GRPO(Group Relative Policy Optimization) 프레임워크 사용 |

| DeepSeek-R1 (이번 연구 모델) |

⦁ DeepSeek-R1-Zero의 가독성 저하와 언어 혼합 문제 해결 ⦁ 기존 모델을 활용 + Cold Start Data 및 Multi-Stage Training 파이프라인 도 |

🚀 DeepSeek-R1-Zero

본 연구의 이전 모델인 DeepSeek-R1-Zero에 대한 내용이다. 해당 모델은 사전 지도 학습 없이 강화 학습만을 사용하여 논리적 추론 능력을 개발한 최초의 LLM이다. 기존 연구는 대부분 지도 데이터를 활용했으나, 본 연구에서는 모델이 Self-Evolution을 하도록 설계되었다. 구조의 큰 특징으로는 '①Group Relative Policy Optimization(GRPO) 알고리즘' 적용과 '②보상 모델(Reward Model)' 설계가 있다.

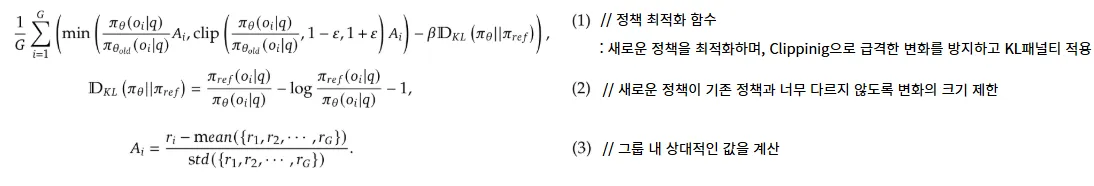

① Group Relative Policy Optimization(GRPO) 알고리즘

⦁ GRPO 알고리즘 : 정책 모델과 동일한 크기의 critic 모델을 사용하지 않고, 그룹 내 상대적인 보상값을 기준으로 정책을 업데이트 하는 방식이다. 이 때, 보상(Advantage)값은 그룹 내 정규화된 보상값으로 정의한다.

⦁ 작동 방식

A. 각 질문에 대해 기존 정책에서 그룹 출력을 샘플링한다.

B. 정책 모델은 목적 함수 J_GPRO를 최대화하는 방향으로 최적화된다.

C. 목적함수는 정책 비율을 제한하는 클리핑 기법을 포함하며, 발산 패널티를 통해 정책 안정성을 유지한다.

* sampling : 한 개의 정해진 출력을 얻는 것이 아니라, 정책에 따라 여러 개의 출력을 생성한 후 이를 이용해 학습하는 과정

⦁ 수학적 정의

② 보상 모델(Reward Model) 설계

보상(Reward)이란, 강화 학습에서 최적화 방향을 결정한다. 크게 정확도 보상과 형식 보상 두 가지로 구성된다.

| 정확도 보상 (Accuracy Rewards) | 정확한 답을 제공하는지 평가하는 보상 모델로, 문제의 정답 여부를 결정할 수 있는 객관적인 기준을 사용함 (수학/코딩) |

| 형식 보상 (Format Rewards) | 모델이 사고 과정을 "<think>"와 "<think>" 태그 사이에 작성하도록 강제하는 보상 모델을 활용함 |

🚀 DeepSeek-R1

DeepSeek-R1-Zero의 성과를 바탕으로 두 가지 핵심 질문이 제기된다 :

1. Cold Start 데이터를 추가하면 추론 성능을 더 향상시키거나 학습 속도를 가속할 수 있을까?

2. 추론 능력 뿐만 아니라 명확하고 일관된 CoT를 생성하며, 일반적인 문제 해결 능력을 갖춘 모델을 만들 수 있을까?

이를 해결하기 위해 4단계 학습 파이프라인을 설계하여 DeepSeek-R1을 훈련하였다.

| 1단계 | 2단계 | 3단계 | 4단계 |

| Cold Start | 강화학습 1단계 : Reasoning-oriented |

Rejection Sampling and Spervised Fine Tuning |

강화학습 2단계 : RL for All Scenarios |

| 초기모델 생성 | RL로 reasoning 능력 강화 | STF | 전반적인 성능 향상 |

① Cold Start

Cold Start란? RL 학습 초기의 불안정성을 방지하기 위해 소량의 긴 체인 오브 소트(CoT) 데이터를 활용하여 모델을 안정화하는 과정

⦁ Data 수집 방법

긴 CoT를 사용한 few-shot prompting을 사용하여 검증을 통해 자세한 답변을 생성하도록 직접 prompting하고,

DeepSeek-R1-Zero 출력을 읽을 수 있는 형식으로 수집하여 human annotator 가 post-processing 을 통해 결과를 정제(refining) 한다.

② Reasoning-oriented Reinforcement Learning

cold start data 로 DeepSeek-V3-Base 를 fine-tuning 한 후에 DeepSeek-R1-Zero 에서 사용된 것과 동일한 대규모 강화 학습 훈련 프로세스를 적용한다.

- 이 단계는 모델의 추론 능력을 향상 시키는데 중점을 두고 있으며, 특히 코딩, 수학, 과학 그리고 논리적 추론과 같은 명확한 솔루션이 있는 잘 정의된 문제들과 같은 추론 중심 (reasoning-intensive) 작업에서 그 성능을 강화하는데 집중한다.

- 반면, 여러 언어가 포함된 프롬프트를 사용하면 CoT 과정에서 언어가 혼합되는 문제가 자주 발생한다. 이를 해결하기 위해 언어 일관성 보상을 훈련 과정에 도입한다

* 언어 일관성 보상(Language Consistency Reward) : 언어를 혼합하지 않고 하나의 언어로 끝까지 답변하도록 개선

③ Rejection Sampling and Supervised Fine-Tuning

Rejection Sampling이란? 모델이 생성한 여러 개의 응답 중 품질이 높은 응답만 선별하여 학습 데이터로 활용하는 방법이다.

⦁ 같은 질문에 대해 여러 개의 샘플을 생성한 후 ruld-based 평가 진행 → 평가 결과가 높은 샘플들만 SFT(지도 학습)에 사용

Supervised Fine-Tuning

모델이 사람이 직접 정답을 제공한 데이터(지도 학습 데이터)를 기반으로 학습하도록 하는 과정

⦁ 진행 과정

- 모델이 생성한 응답을 사람 or 다른 모델(V3)과 비교하여 평가하고 선택

- 모델을 아래와 같은 데이터로 추가 학습(fine tuning) 하여 정확도를 높임

⦁ 활용하는 데이터

| 추론 데이터 | - 논리적인 사고를 필요로 하는 문제 - Rejection sampling을 거쳐 고품질 답변을 모아 학습 |

| 비추론 데이터 | - 글쓰기, 사실 기반 질의응답(FAQ), 자기 인식, 번역 등의 데이터 - V3 파이프라인을 활용하여 기존 SFT 데이터셋을 재사용 |

④ Reasoning-Oriented Reingorcement Learning

모델을 인간의 선호도에 더욱 잘 맞추기 위해, 모델의 유용성과 무해성을 개선하면서 동시에 추론 능력도 강화하는 2차 강화학습 단계를 도입

| 유용성(helpfulness) | 모델의 최종 요약에 초점을 맞춰 평가 |

| 무해성(harmlessness) | 모델이 생성하는 전체 응답을 검토하여 잠재적인 위험 요소, 유해한 내용이 포함되지 않도록 조정 |

III. Experiment

본 연구의 실험 결과로, 여러 영역에서 가장 높은 성능을 달성했음을 확인할 수 있었다.

< 공부할 때 참고한 블로그 >

[1] databoom.tistory

[2] velog.io/@d4r6j