논문명: DeepSeek-V3 Technical Report

저자: DeepSeek-AI

출간지: SCIENCE CHINA Technological Sciences

발간일: 27 Dec 2024

본 포스터는 DeepSeek-V3 리포트를 읽고 리뷰한 것이다. 아키텍처와 실험 결과 위주로 보기 쉽게 정리하는 것을 목표로 두었다. (내용이 너무 많아서)

I. 모델 정보

| 항목 | 설명 |

| 총 파라미터 수 | 671B |

| 활성화 파라미터 수 | 토큰 당 37B개 활성화 |

| 아키텍처 | Multi-head Latent Attnetion(MLA) 및 DeepSeekMoE 유지(V2에서 검증 완료) |

| 새로운 전략 | 보조 손실(auxilary loss) 없이 로드 밸런싱, 다중 토큰 예측(multi-token Prediction) |

| 학습 시간 | 2.788M 시간 - H800 GPU |

II. Architecture

2.1 전체 아키텍처

전체 아키텍처는 역시 Transformer를 따르며, basic한 아키텍처로 MLA module과 DeepSeekMoE를 보면된다.

2.2 Basic Architecture

☑️Multi-head Latent Attention(MLA)

우선, 우리가 아는 Multi-head Attention과 간단하게 비교하자면 다음과 같은 특징을 갖는다.

| Multi-head Attn | - 매번 새로운 Query가 들어올 때마다 key와 value를 새롭게 생성하고, 이를 기반으로 어텐션 수행 - 추론(inference) 중에도 계속해서 key와 value를 새로 계산해야하므로, 메모리 사용량과 연산량 증가 |

| Multi-head Latent Attn | - key와 value에 대한 값을 캐싱함으로써 재사용을 통해 연산량을 크게 줄임 |

즉, 매번 key와 value를 새롭게 생성해 다시 연산하는 부분을 줄인 것이다.

- MLA의 특징 정리

1. 기존 MHA와의 차이점 : 잠재 공간(latent space)를 활용하여 연산량을 줄이는 방식 적용

2. Latent vector의 역할 : 미리 학습된 상태로 존재하는 key와 value를 의미 (=고정된 값으로 보면 된다)

3. 수학적 정의

☑️ DeepSeekMoE

- MoE란?) Mixture of Experts란 뜻으로, 다수의 Experts 네트워크 중 일부만 활성화하여 연산화하는 방식이다.

- 주요 요소 (전체 아키텍처 그림 참고)

| hidden input | 입력 데이터가 라우터를 통해 적절한 experts로 분배됨 |

| router | 입력 데이터를 기반으로 어떤 expert를 활성화할지 정함 - Top K 방식 : 상위 K개의 전문가를 선택하여 연산 수행 |

| experts | - Routed Experts(파랑) : Router를 통해 동적으로 선택되는 experts - Shared Experts(녹색) : 항상 활성화되는 experts |

- 문제점

단, 이러한 기존 방식에는 문제점이 있다. 일부 Experts만 집중적으로 사용됨으로써 특정 네트워크에 과부하가 걸리고 다른 Experts는 사용되지 않는다는 점이다. 이에 로드밸런싱을 강제하기 위하여 보조 손실을 적용하여 모든 Experts가 고르게 사용되도록 하는 방식을 채택하였다.

V3로 넘어오면서는 새로운 라우팅 전략을 도입하게 되는데 아래 설명하도록 하겠다.

2.3 Advanced Architecture

✅보조 손실 없이 로드 밸런싱(Auxiliary-Loss-Free Load Balancing)

[1] Affinity Score 기반 Expert 선택

- 각 토큰 t에 대해 Expert i와의 score 계산

- 편향 값 b를 추가하여 Top K 전문가 선택

[2] 훈련 과정에서 동적 조정

- 과부화 된 Expert : 편향값을 감소시켜, 해당 Expert의 선택 확률을 줄임

- 부하가 적은 Expert : 편향값을 증가시켜, 더 많은 토큰이 해당 Expert로 배정되도록 유도

[3] 보조 손실 없이도 Load Balancing 유지

> 기존에는 보조 손실을 추가하여 Expert 간의 균형을 유지했지만, DeepSeek-V3에서는 편향 값 조정만으로도 효과적인 로드 밸런싱을 달성할 수 있음

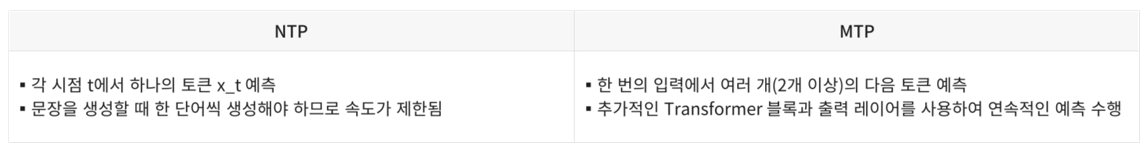

✅멀티 토큰 예측(Multi-Token Prediction, MTP)

기존 트랜스포머 모델들은 한 번에 하나의 토큰만 예측하는 Next Token Prediction을 사용했다. DeepSeek-V3에서는 한 번에 여러 개의 토큰을 예측하는 MTP 기법을 도입하여 훈련과 추론 속도를 향상시킨다.

III. Pre-Training

3.1 DeepSeek-V3 하이퍼파라미터 설정

3.2 Evaluation

전반적인 성능

- 대부분의 평가에서 가장 높은 성능 기록

- Code, Math task는 모든 부분 최고 성능

- MTP 전략의 성능 효율성 : Small, Big MoE 모두 성능 향상을 보임

V. Post-Training